El 40% del tiempo de un Demand Planner se quema intentando explicar por qué falló el pronóstico del mes anterior. Mientras tanto, el inventario sigue desalineado, los stockouts se acumulan y las decisiones de compra se toman con datos de hace dos semanas.

La pregunta no es si tus datos pueden predecir el futuro de tu Supply Chain. La pregunta es cuánto dinero estás dejando sobre la mesa mientras sigues dependiendo solo de Excel y tu intuición.

La analítica predictiva en Supply Chain combina datos históricos, machine learning y señales en tiempo real para estimar la probabilidad de eventos futuros. Te dice qué es probable que ocurra, con qué nivel de confianza y qué hacer al respecto antes de que impacte tu operación.

Estudios recientes resaltan que el mercado de analítica predictiva supera los 18.000 millones de dólares en 2024, con una tasa de crecimiento anual por encima del 25–28%, reforzado por la adopción en supply chain y logística.

En Latinoamérica, el 70.07% de los profesionales en Supply Chain ha manifestado que la analítica predictiva y prescriptiva es su principal prioridad de implementación tecnológica en 2026.

Aquí te explicamos exactamente cómo funciona, qué componentes técnicos necesitas, qué casos de uso generan más ROI y cómo empezar sin convertir esto en un proyecto de tres años que nunca sale de la fase piloto.

Es el uso sistemático de datos históricos, datos en tiempo real, técnicas estadísticas avanzadas y algoritmos de machine learning para estimar la probabilidad de eventos futuros a lo largo de tu Supply Chain. Tiene como meta tomar decisiones proactivas sobre demanda, inventario, abastecimiento, transporte y nivel de servicio.

A diferencia del reporting descriptivo (qué pasó la semana pasada) o el análisis diagnóstico (por qué se desplomaron las ventas en marzo), la analítica predictiva se centra en qué es probable que ocurra y con qué nivel de confianza, habilitando ajustes anticipados antes de que los problemas te exploten en la cara.

Entender esta diferencia es fundamental porque muchas empresas creen que están haciendo analítica predictiva cuando en realidad solo están mirando dashboards bonitos del mes pasado

La analítica predictiva es el puente entre saber qué pasó y decidir qué hacer. Sin ella, estás volando a ciegas.

¿Cómo combina datos históricos, machine learning y datos en tiempo real?

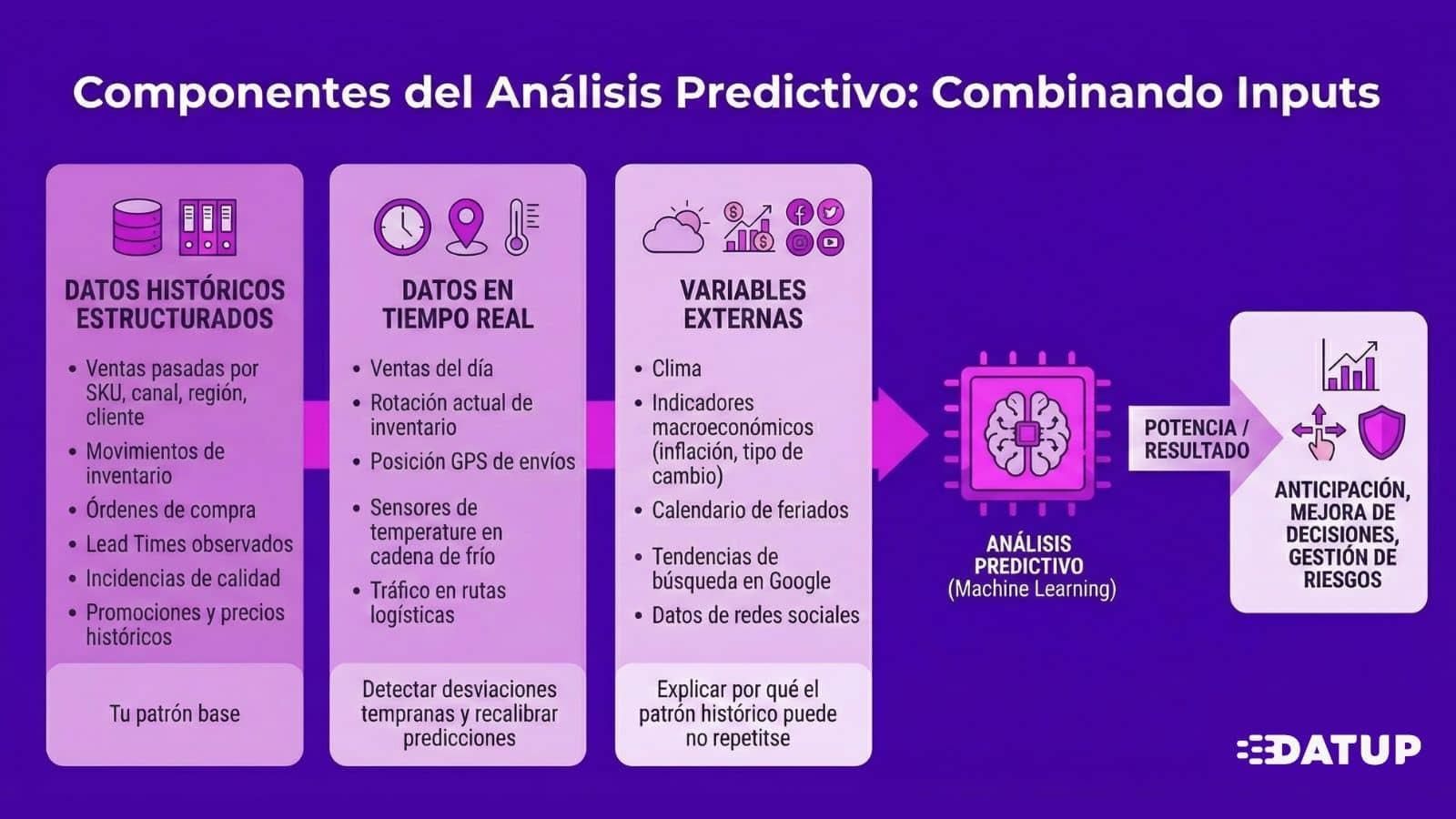

La potencia viene de combinar tres tipos de inputs:

Datos históricos estructurados: Ventas pasadas por SKU, canal, región y cliente. Movimientos de inventario. Órdenes de compra y Lead Times observados. Incidencias de calidad. Promociones y precios históricos. Este es tu patrón base.

Datos en tiempo real: Ventas del día, rotación actual de inventario, posición GPS de envíos, sensores de temperatura en cadena de frío, tráfico en rutas logísticas. Te permiten detectar desviaciones tempranas y recalibrar predicciones antes de que sea demasiado tarde.

Variables externas: Clima, indicadores macroeconómicos (inflación, tipo de cambio), calendario de feriados, tendencias de búsqueda en Google, datos de redes sociales. Estas señales explican por qué el patrón histórico puede no repetirse: una ola de calor dispara la demanda de bebidas, una huelga portuaria impacta tiempos de importación.

Los algoritmos de machine learning procesan estos tres tipos de datos simultáneamente, detectan patrones no lineales y correlaciones que el análisis tradicional no captura.

La diferencia práctica:

Un modelo de Forecast tradicional te dice que históricamente vendes 1,000 unidades por semana.

Un modelo predictivo con ML te dice que la próxima semana vas a vender 1,340 porque detectó clima 8°C más caliente, un feriado largo y stockouts de tu competidor en tres regiones.

Esas 340 unidades son la diferencia entre cumplir o no tu nivel de servicio.

El objetivo final es tomar mejores decisiones antes de que los problemas impacten tu P&L.

Esto se traduce en acciones concretas:

La analítica predictiva no elimina la incertidumbre. Te da visibilidad anticipada del rango probable de escenarios y te permite prepararte en lugar de reaccionar.

Implementar analítica predictiva no es instalar un software y ya, es un proceso iterativo que conectan datos, modelos y decisiones operativas.

Todo empieza aquí. Si tus datos están fragmentados, incompletos o llenos de errores, tus predicciones serán basura envuelta en ecuaciones bonitas.

Necesitas consolidar información de tus sistemas core: ERP (órdenes de venta, compra, producción, movimientos de inventario), WMS (entradas, salidas, ubicaciones, rotación), TMS (rutas, tiempos de entrega), CRM (comportamiento de clientes). También sensores IoT si los tienes: GPS de vehículos, temperatura en cámaras frías, niveles de llenado.

Hemos visto empresas con cinco fuentes de información distintas, datos de ventas en hojas de cálculo enviadas por email e información de proveedores en PDFs. Si este es tu caso, la recopilación de datos no es un paso técnico menor, es el 60% del esfuerzo del proyecto.

Los datos crudos son un desastre. SKUs duplicados con códigos distintos, clientes con tres nombres diferentes, fechas en formatos incompatibles, movimientos de inventario que no cuadran con órdenes de compra.

Si dedicas menos del 50% del tiempo del proyecto a preparación de datos, probablemente tus modelos van a fallar. Los científicos de datos serios pasan 70-80% del tiempo limpiando datos. No es sexy, pero es donde se gana o se pierde el juego.

Aquí entran los algoritmos de machine learning. Pero antes de saltar a modelos complejos, necesitas definir bien qué estás intentando predecir y con qué horizonte temporal.

Para Forecasting de demanda, los modelos más usados:

El entrenamiento divide tus datos en conjuntos de entrenamiento (70-80%), validación (10-15%) y prueba (10-15%). Mides performance con métricas de negocio: MAPE, RMSE, bias. Y siempre comparas contra un baseline simple para demostrar que el modelo realmente agrega valor.

Cuidado con el overfitting (o sobreajuste): Un modelo puede memorizar ruido histórico y perder capacidad de generalizar. La validación cruzada y el monitoreo continuo en producción son críticos.

Una vez validado, el modelo entra en producción. Recibe datos frescos (ventas de ayer, inventario de hoy, clima proyectado) y produce forecasts actualizados, probabilidades de riesgo y recomendaciones de niveles de inventario.

Para decisiones de Supply Chain, necesitas más que un punto estimado:

"El Forecast es 10,000 unidades, con un intervalo del 80% entre 8,500 y 11,800, y una probabilidad del 15% de superar 12,500 unidades."

Esa información te permite diseñar políticas de inventario robustas y planes de contingencia reales.

En Datup, nuestros modelos generan forecasts granulares por SKU, ubicación, canal y cliente, con intervalos de confianza calibrados y explicaciones automáticas de los drivers principales.

Las predicciones son inútiles si no se traducen en decisiones concretas. No basta con decir "el Forecast subió 20%". Necesitas traducir eso en:

"Debes anticipar la siguiente orden de compra del proveedor X en una semana, incrementar el Stock de Seguridad en el CD Norte de 500 a 700 unidades y priorizar producción del SKU Y en la planta 2."

Alertas automáticas cuando el modelo detecta probabilidad de stockout superior al 30%, proveedores con scoring de riesgo elevado o retrasos proyectados que impactan entregas comprometidas. Estas alertas llegan por email, push o se integran directamente en tu WMS o sistema de compras.

Si tus usuarios finales no pueden actuar fácilmente sobre las predicciones, el proyecto fracasa aunque los modelos sean técnicamente impecables.

Los modelos predictivos no son "pon y olvida". Sin monitoreo, se degradan y producen predicciones cada vez peores.

Las empresas maduras implementan prácticas de MLOps que automatizan todo el ciclo: versionado, pipelines de reentrenamiento, monitoreo en tiempo real, rollback automático si un modelo nuevo empeora. Esto convierte la analítica en una capacidad operativa robusta, no en un proyecto puntual.

Estudios documentados reportan mejoras del 30-40% en precisión de Forecast con modelos predictivos avanzados vs. métodos tradicionales. Eso se traduce en:

La analítica predictiva combina forecast de demanda con predicción de variabilidad y tiempos de reabastecimiento para calcular stock de seguridad, punto de reorden y lotes óptimos por SKU, ubicación y canal. Menos inventario promedio significa menos espacio, menos obsolescencia, menos merma, menos costo financiero. Reducciones de 15-25% en costo total de inventario son habituales.

Modelos como ARIMA y SARIMA siguen siendo extremadamente relevantes: interpretables, requieren menos datos y funcionan bien cuando los patrones históricos se mantienen estables.

Hemos visto equipos que insisten en usar solo modelos tradicionales para todo su portafolio qur resultan en pronósticos aceptables para el 60% de los SKUs (los estables) y desastres en el 40% restante. La solución no es abandonar los clásicos, sino combinarlos con técnicas más avanzadas según la naturaleza de cada producto.

Gradient Boosting (XGBoost, LightGBM): Los reyes del Forecasting avanzado. Incorporan cientos de variables y detectan automáticamente qué combinaciones importan para cada SKU.

El problema es que son cajas negras. Un planner experimentado no confía en lo que no logra entender. Por eso la explicabilidad es crítica — técnicas como SHAP values para mostrar qué variables influyeron en cada predicción.

En Datup, trabajamos con múltiples modelos, no solo con uno. Y también entregamos explicaciones claras de qué movió cada pronóstico, permitiendo que el planner valide con criterio antes de ejecutar.

La simulación Monte Carlo produce distribuciones de probabilidad en lugar de un único punto. Esto permite calcular exactamente cuánto buffer necesitas para alcanzar un fill rate objetivo considerando la variabilidad real de demanda y lead time.

También sirve para escenarios "qué pasaría si": ¿Qué pasa si cierran un puerto durante dos semanas? ¿Qué impacto tiene perder un proveedor crítico? Fundamentales para planes de contingencia.

La implementación de analítica predictiva no suele fallar por la tecnología, sino, por los datos, la integración y las personas.

El problema número uno, sin discusión. Datos faltantes, duplicados, inconsistentes, desactualizados... Alrededor del 90% de profesionales de datos perciben que la alta dirección no presta suficiente atención a la calidad de datos. Se recomienda hacer auditorías regulares, controles en el punto de captura y data governance real con responsables y estándares.

ERPs antiguos, múltiples instancias por país, WMS y TMS de diferentes proveedores, hojas de cálculo por correo. En Datup, nos encargamos directamente de la integración con tu ERP, CRM, WMS y TMS, coordinando con tu equipo de IT sin interrumpir la operación.

Escasez de perfiles que combinen conocimiento de Supply Chain con habilidades técnicas en estadística y ML. La solución pasa por capacitación interna, equipos mixtos y plataformas que democraticen la analítica, herramientas donde el usuario de negocio opera modelos avanzados sin ser científico de datos.

El riesgo opuesto a la resistencia al cambio. Los modelos pueden fallar ante eventos sin precedente, cambios estructurales o errores en datos de entrada. Mantener un "human in the loop" es parte de la gestión de riesgo inteligente.

No sirve: "Queremos mejorar la precisión del forecast."

Sirve: "Queremos reducir el MAPE de categorías A y B de 35% a 25% en 6 meses, traducido en 40% menos quiebres y 15% menos inventario promedio."

Un modelo simple con datos limpios supera a un modelo sofisticado con datos basura. Auditorías regulares, eliminación de duplicados, validación en punto de captura, data governance con responsables por dominio.

La analítica no puede vivir en un silo. Si el planner debe abrir un sistema paralelo, descargar un Excel y copiar números manualmente, la adopción será baja. La integración debe ser fluida.

Las implementaciones exitosas dedican entre 20% y 30% del esfuerzo a capacitación y gestión del cambio. La tecnología más avanzada del mundo no sirve si los usuarios no la usan o no confían en ella.

Sin MLOps, los proyectos se convierten en "modelos zombie": técnicamente desplegados pero generando valor decreciente porque nadie los mantiene.

Ventas comparte promociones, compras valida viabilidad de órdenes sugeridas, finanzas alinea con flujo de caja, IT garantiza integración. La analítica predictiva debe dejar de ser "el proyecto del área de planeación" para convertirse en una capacidad estratégica de toda la organización.

La analítica predictiva en Supply Chain no es algo a lo que aspiramos en el futuro, hoy ya hay empresas usándola y están capturando beneficios medibles:

Nos enriquece de beneficios tangibles, pero también posee desafíos para su implementación y ROI que puede generar para la organización.

La diferencia entre las empresas que capturan estos beneficios y las que siguen peleando con Excel no es presupuesto ni tecnología, es decisión estratégica y cambio cultural.

.png)

%20Software%20for%202025%20(4).png)

.png)